Hadoop基础教程:HDFS常用Shell操作

最新学讯:近期OCP认证正在报名中,因考试人员较多请尽快报名获取最近考试时间,报名费用请联系在线老师,甲骨文官方认证,报名从速!

我要咨询(1)列出文件目录:Hadoop fs -ls 目录路径

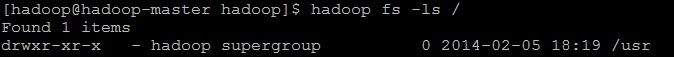

查看HDFS根目录下的目录:Hadoop fs -ls /

递归查看HDFS根目录下的目录:Hadoop fs -lsr /

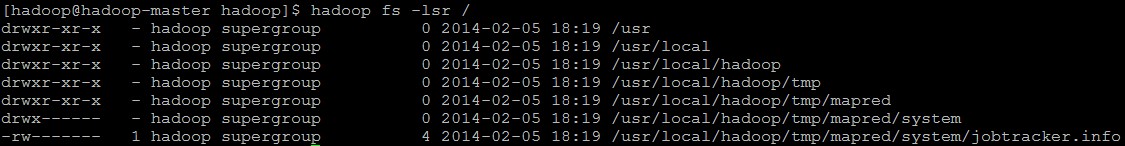

(2)在HDFS中创建文件夹:Hadoop fs -mkdir 文件夹名称

在根目录下创建一个名称为di的文件夹:

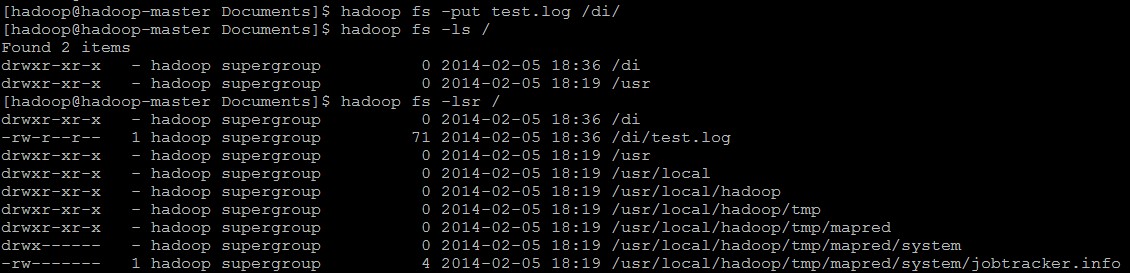

(3)上传文件到HDFS中:Hadoop fs -put 本地源路径 目标存放路径

将本地系统中的一个log文件上传到di文件夹中:Hadoop fs -put test.log /di

*PS:我们通过Hadoop Shell上传的文件是存放在DataNode的Block(数据块)中的,通过Linux Shell是看不到文件的,只能看到Block。因此,可以用一句话来描述HDFS:把客户端的大文件存放在很多节点的数据块中。

(4)从HDFS中下载文件:Hadoop fs -get HDFS文件路径 本地存放路径

将刚刚上传的test.log下载到本地的Desktop文件夹中:Hadoop fs -get /di/test.log /home/hadoop/Desktop

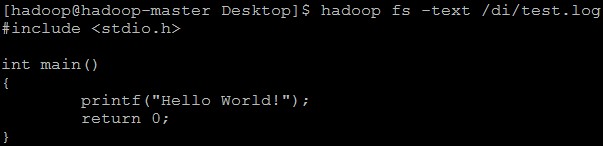

(5)直接在HDFS中查看某个文件:Hadoop fs -text(-cat) 文件存放路径

在HDFS查看刚刚上传的test.log文件:Hadoop fs -text /di/test.log

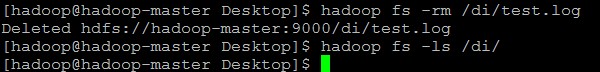

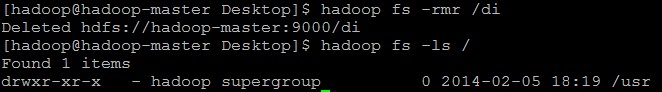

(6)删除在HDFS中的某个文件(夹):Hadoop fs -rm(r) 文件存放路径

删除刚刚上传的test.log文件:Hadoop fs -rm /di/test.log

删除HDFS中的di文件夹:Hadoop fs -rmr /di

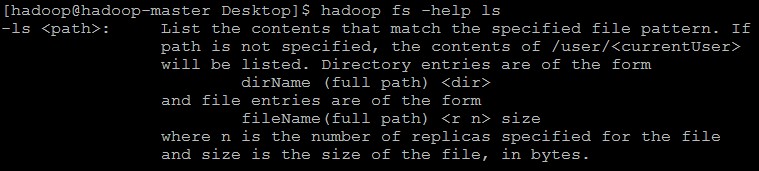

(7)善用help命令求帮助:Hadoop fs -help 命令

查看ls命令的帮助:Hadoop fs -help ls